Gemini Nano (Part 3): 클라우드를 넘어 '하이브리드 AI' 시대로

모든 것을 클라우드에 묻지 마세요. 내 기기가 스스로 생각할 때, 진정한 개인화가 완성됩니다. 2026년 엣지 AI 기술 로드맵.

서론: 온디바이스 AI가 필연적인 이유

지난 2년(2023-2024)간 우리는 '거거익선(Bigger is Better)'의 함정에 빠져 있었습니다. GPT-4, Gemini Ultra 같은 거대 모델들은 놀랍지만 너무 비싸고 느립니다. 그리고 결정적으로, "내 개인정보가 서버로 전송되는 것이 안전한가?"라는 근본적인 물음에 답하지 못했습니다.

이제 패러다임이 바뀝니다. 데이터가 발생하는 그곳(Edge)에서 즉시 처리하고, 정말 필요한 경우에만 클라우드의 도움을 받는 '하이브리드 AI(Hybrid AI)'가 2026년의 표준이 될 것입니다.

Part 1. 핵심 기술: 어떻게 더 작게 만드는가?

1. 극단적 양자화 (Extreme Quantization): 1-bit LLM

마이크로소프트의 'BitNet' 연구가 불을 지폈습니다. 기존 16비트 모델을 1.58비트(삼진법: -1, 0, 1)로 줄여도 성능 저하가 거의 없다는 것이 증명되었습니다. 이는 메모리 사용량을 10배 줄이고, 전력 소모를 70배 줄일 수 있음을 의미합니다. 이제 스마트워치에서도 LLM이 돌아가는 시대가 옵니다.

2. MoE (Mixture of Experts)의 소형화

하나의 거대한 모델 대신, 특정 분야에 특화된 수십 개의 작은 '전문가' 모델들을 기기에 탑재합니다. "수학 문제"가 들어오면 수학 전문가 모델만 깨워서 답하게 함으로써 효율성을 극대화합니다.

Part 2. 하이브리드 아키텍처 (Cloud-Edge Collaboration)

온디바이스 AI만으로는 한계가 있습니다. 최적의 해법은 둘을 섞는 것입니다.

- Level 1 (Privacy Filter): 민감한 개인정보(이름, 주소, 계좌번호)는 기기 내에서 처리하거나 마스킹(가림) 처리하고, 안전한 데이터만 클라우드의 초거대 모델로 보냅니다.

- Level 2 (Draft & Refine): 기기의 작은 모델이 0.1초 만에 빠르게 '초안'을 작성해서 보여주고, 사용자가 만족하지 않으면 백그라운드에서 클라우드 모델이 고품질 답변을 생성해 대체합니다.

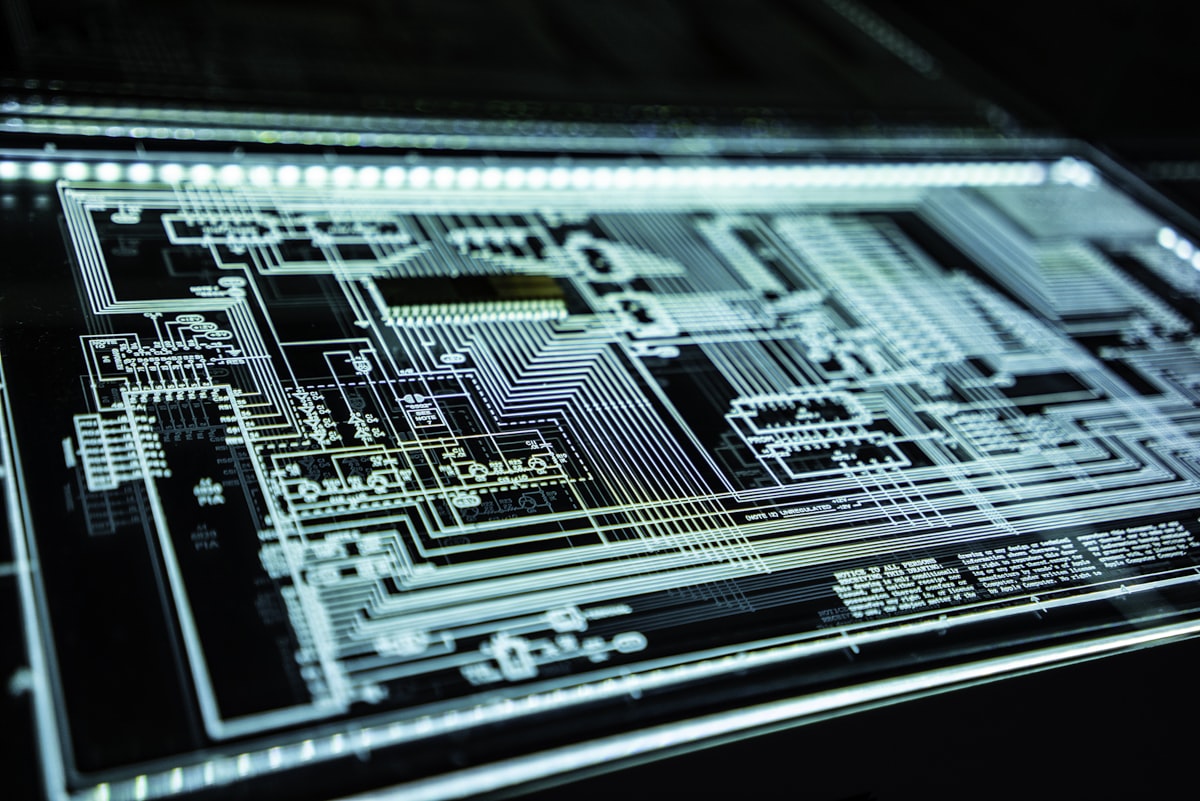

Part 3. 새로운 하드웨어 생태계 (NPU & PIM)

1. NPU의 보편화

CPU, GPU에 이어 NPU(Neural Processing Unit)가 모든 칩셋의 기본 사양이 되었습니다. 애플의 M시리즈, 퀄컴의 스냅드래곤 X 엘리트, 인텔의 루나레이크 모두 수십 TOPS(초당 조 횟수 연산)의 NPU 성능을 경쟁하고 있습니다.

2. PIM (Processing-in-Memory)

데이터가 메모리와 프로세서 사이를 오가는 과정에서 병목현상이 발생합니다. 삼성전자와 SK하이닉스는 메모리 자체에서 연산을 수행하는 PIM 기술을 상용화하여, 저전력-초고속 AI의 기반을 마련했습니다.

Part 4. 2026년 미래 시나리오

1. 진정한 개인비서 (Personal Agent)

지금의 시리(Siri)나 빅스비는 클라우드 서버의 앵무새일 뿐입니다. 미래의 온디바이스 에이전트는 내 스마트폰에 저장된 모든 사진, 문자, 통화 기록을(외부 유출 없이) 학습하여 나보다 나를 더 잘 아는 비서가 됩니다. "작년 크리스마스 때 갔던 그 식당 예약해 줘"라는 명령이 가능해집니다.

2. 6G와의 결합 (Ambient AI)

6G 통신망은 지연 시간(Latency)이 거의 제로에 가깝습니다. 주변의 가로등, CCTV, 자율주행차 등 모든 사물에 탑재된 엣지 AI들이 실시간으로 협동하여 도시 전체를 하나의 지능형 유기체처럼 운영하게 됩니다.

결론: 기술은 인간을 향해야 한다

온디바이스 AI의 궁극적인 가치는 '성능'이 아니라 '인간 중심(Human-centric)'에 있습니다. 통신이 단절된 재난 상황에서도 생명을 구하고, 거대 기업의 감시로부터 개인의 프라이버시를 지키는 기술. Gemini Nano와 같은 경량화 모델들이 그 희망의 씨앗이 될 것입니다.

자주 묻는 질문 (FAQ)

Q1: 폰 배터리가 너무 빨리 닳지 않을까요?

초기에는 문제가 되었으나, NPU의 전력 효율 개선과 1-bit 양자화 같은 소프트웨어 최적화로 인해 배터리 소모량은 획기적으로 줄어들고 있습니다. 오히려 통신을 덜 쓰기 때문에 전체 전력 소모는 비슷하거나 적을 수 있습니다.

Q2: 1-bit 모델은 멍청하지 않나요?

놀랍게도 아닙니다. 모델의 크기(파라미터 수)를 충분히 키우면 표현력은 유지하면서 연산량만 줄일 수 있습니다. 이미 Llama 3 급의 성능을 보여주는 1.58bit 모델들이 나오고 있습니다.

Q3: 애플 인텔리전스(Apple Intelligence)와 차이점은 뭔가요?

애플의 접근 방식도 온디바이스 중심이라는 점에서는 같습니다. 다만 구글의 Gemini Nano는 더 개방적인 생태계(안드로이드, 웹, IoT)를 지향하며, 다양한 하드웨어 제조사들이 사용할 수 있다는 점에서 확장성이 큽니다.